Ollama 在mac上开放局域网访问

Ollama 在mac上开放局域网访问

我们在mac上安装ollama之后只能用作本地使用,但我想开放服务,让局域网内的其他设备也来使用mac上的ollama服务。

问题重现

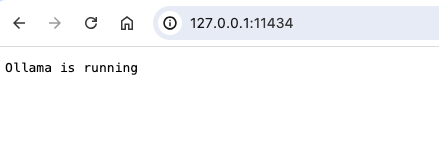

我们在本地安装Ollama模型后通过127.0.0.1:11434访问正常返回

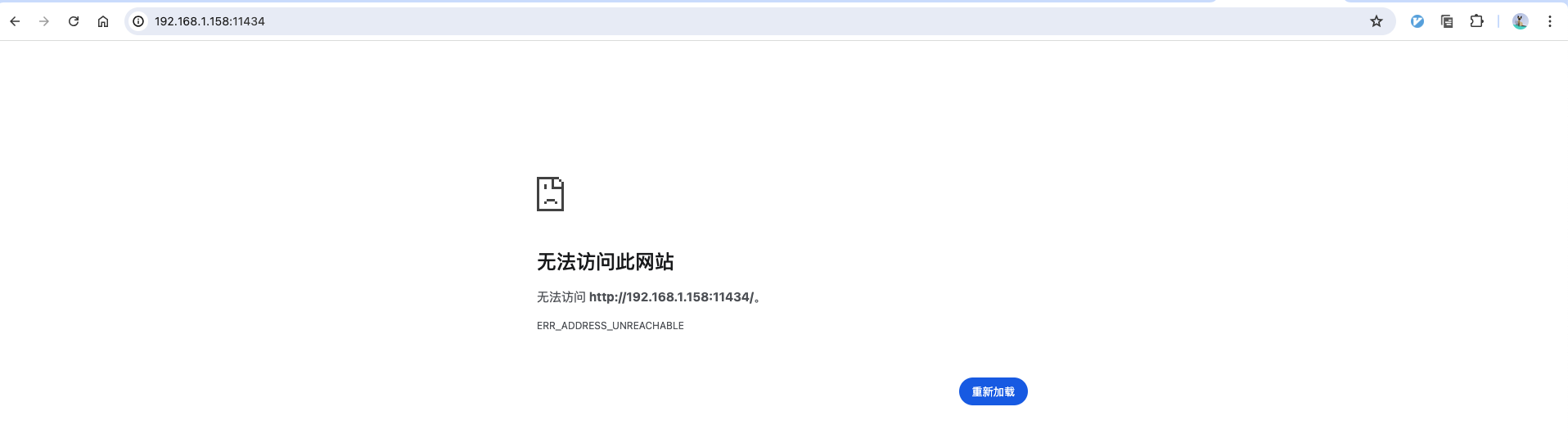

但是无法通过局域网IP访问如: http://192.168.1.158:11434

解决方案

在windows上开放过服务的小伙伴就知道,需要添加环境变量 OLLAMA_HOST 才能开放外网访问

export OLLAMA_HOST=0.0.0.0:11434

然后我就在 /etc/profile 和 ~/.zshrc 中均添加了此变量,然后启动ollama,发现还是无法访问。

但是通过命令行执行命令 ollama serve 启动后, http://192.168.1.158:11434 可成功访问。

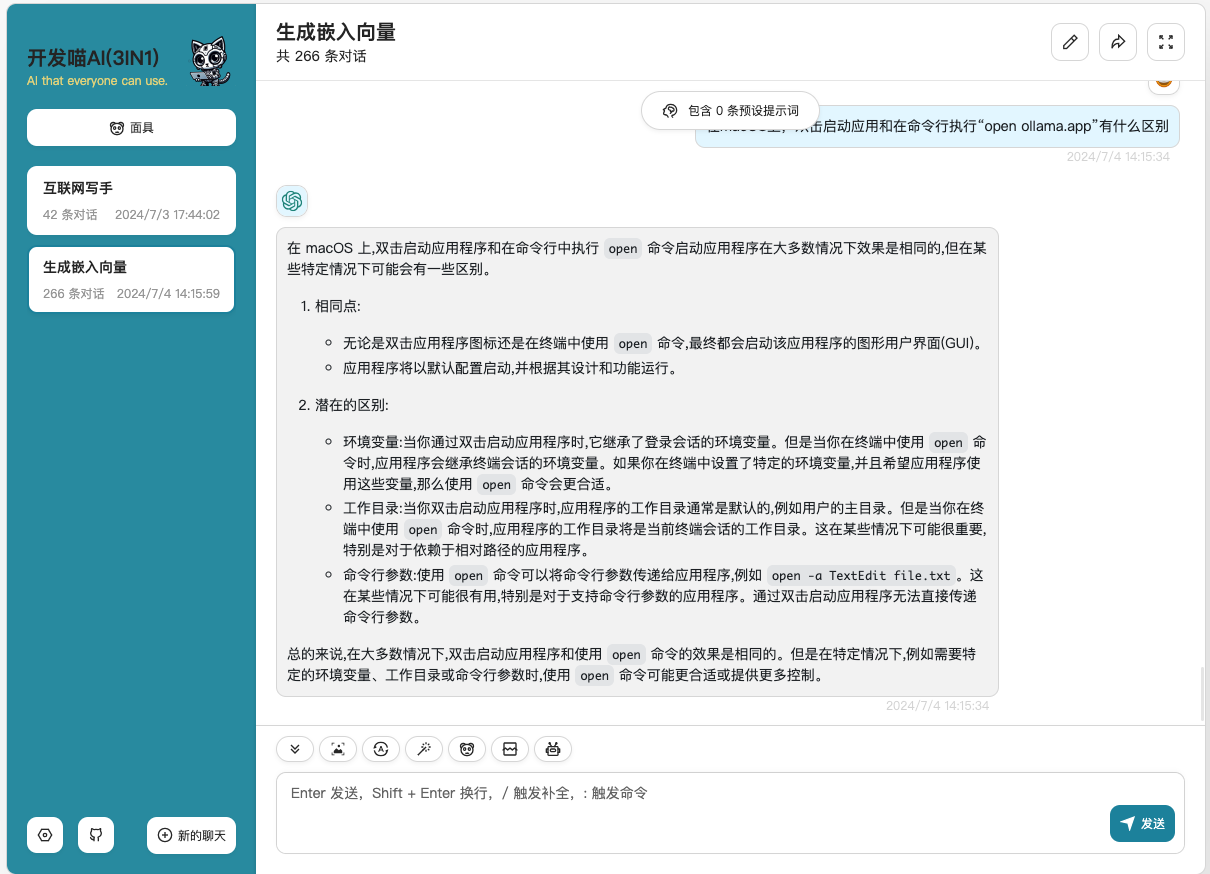

然后我就没想明白,也找不到合适的资料,然后就去问了claude3-opus(个人觉得超级好用),然后发现:

这一下就明白了。

在这里也给大家推荐一下 开发喵AI 这个工具,涵盖了市面的最强模型,包括GPT-4、claude3系列、gemma2系列模型,包括他们的所有收费模型,效果杠杠滴。

最终方案

- 修改 /etc/profile 文件添加环境变量

sudo sh -c 'echo "export OLLAMA_HOST=0.0.0.0:11434" >> /etc/profile'

- 执行 launchctl 命令添加环境变量

launchctl setenv OLLAMA_HOST "0.0.0.0:11434"

这样不论是命令行 ollama serve 启动,还是双击ollama应用图标启动,都可以外网访问。