AnythingLLM 不显示 Ollama 模型

AnythingLLM 不显示 Ollama 模型

今天遇到了AnythingLLM 不显示 Ollama 模型的问题,并且不同安装方式的解决方法都不一样。

出现这个问题的原因是AnythingLLM无法正确访问ollama服务。

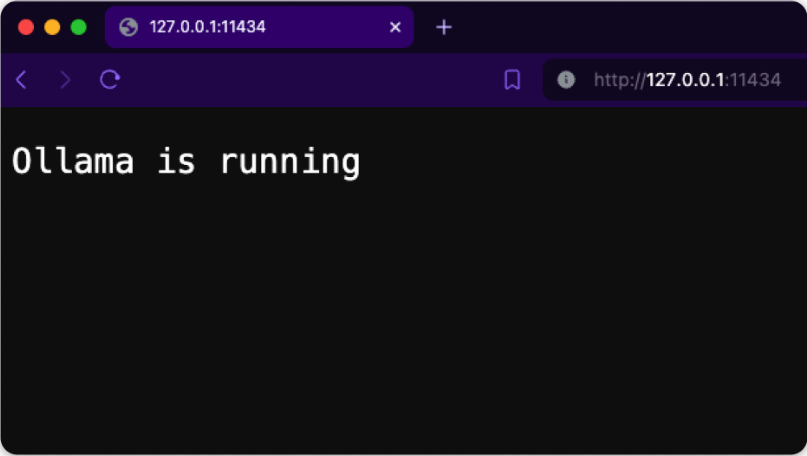

首先确保 ollama 在你的机器后台运行,你可以通过访问来确认http://127.0.0.1:11434

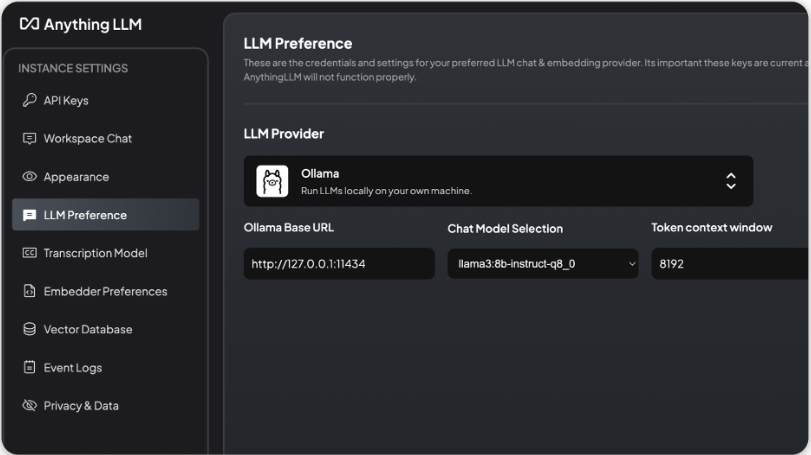

AnythingLLM 桌面版本

AnythingLLM 桌面版的话,则使用http://127.0.0.1:11434AnythingLLM 上的 Ollama 基本 URL,来访问ollama服务。

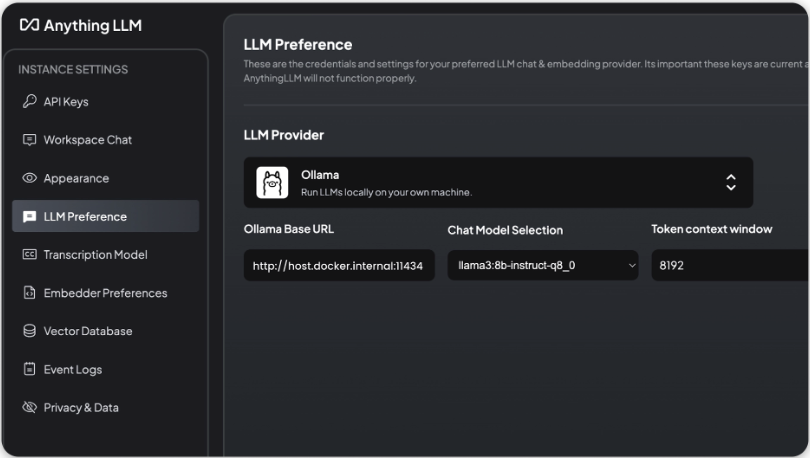

AnythingLLM Docker 版本

AnythingLLM Docker 版本,使用http://host.docker.internal:11434在 AnythingLLM 上用作访问Ollama服务的基本 URL

提示➤➤ 在 Linux 上

http://host.docker.internal:xxxx不起作用。请使用http://172.17.0.1:xxxx来模拟此功能。