利用LLaMA_Factory微调llama38b大模型

利用LLaMA_Factory微调llama3:8b大模型

安装模型文件

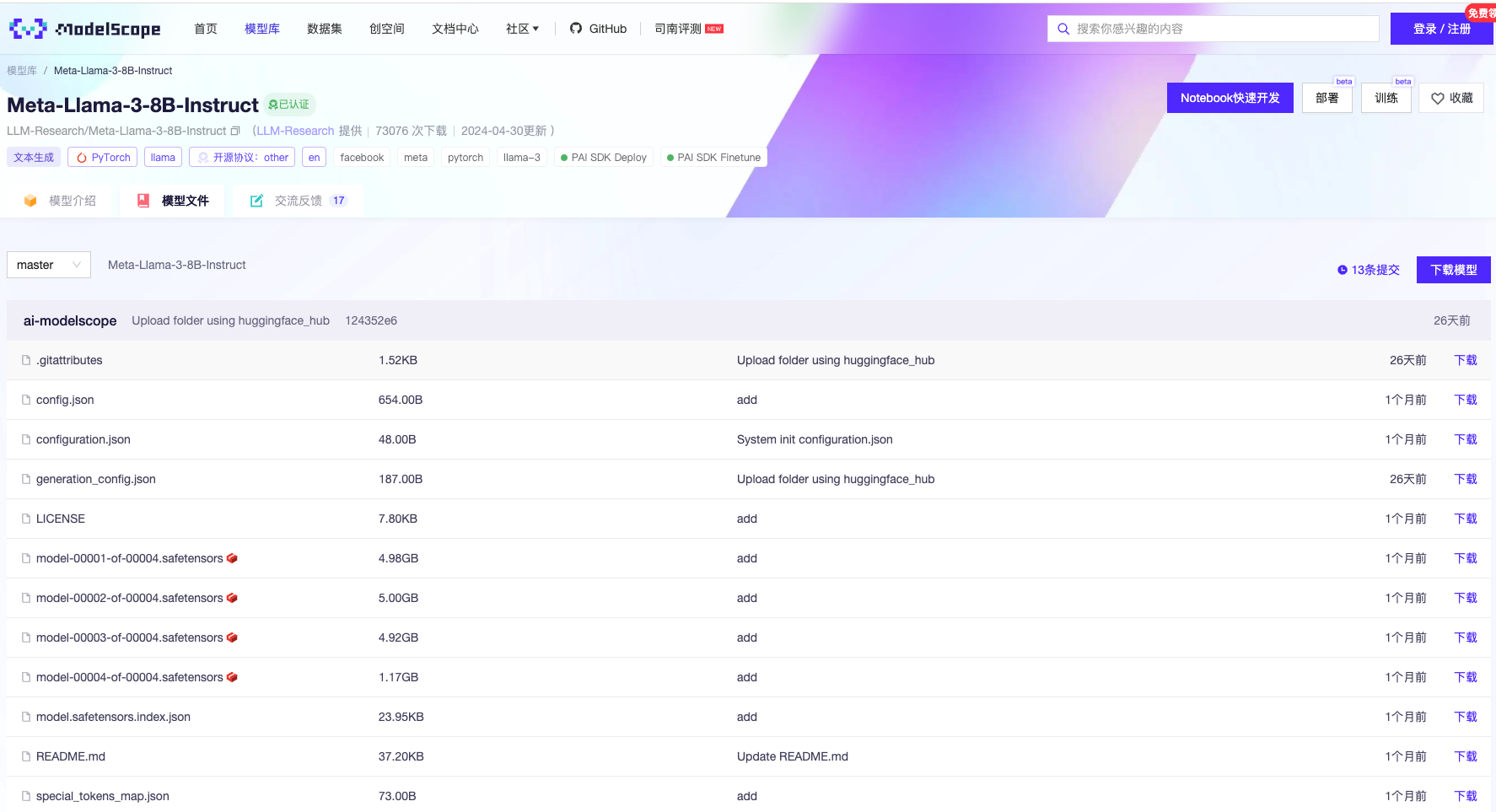

下载地址(魔塔):https://modelscope.cn/models/LLM-Research/Meta-Llama-3-8B-Instruct/files

点击下载模型,复制git命令:

git clone https://www.modelscope.cn/LLM-Research/Meta-Llama-3-8B-Instruct.git

配置LLaMA-Factory

昨天的文章中已经讲过了它的安装配置,这里就不过多赘述

安装依赖

激活虚拟环境

conda activate llama_factory

安装依赖

pip install -e .[metrics,modelscope,qwen]

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

安装tensorboard

pip install tensorboard

设置环境变量

Set USE MODELSCOPE HUB=1

运行LLaMA-Factory的webui.py

python src/webui.py

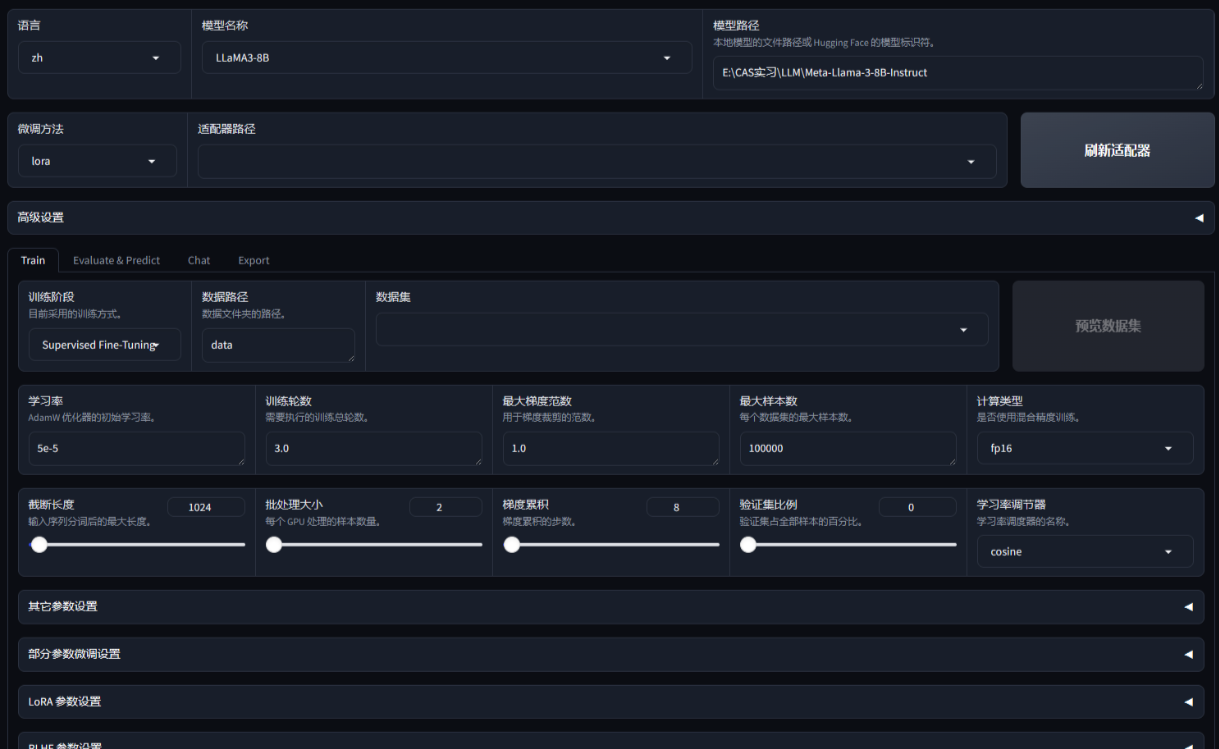

会打开如下网页(初始界面)

微调模型

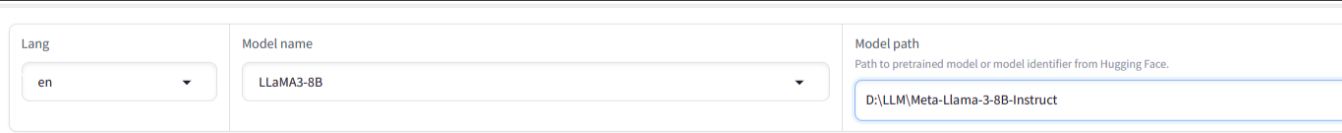

在“Model name”中选择“LLaMA3-8B”,将“Model path”中的路径填写Meta-Llama-3-8B-Instruct文件夹的路径

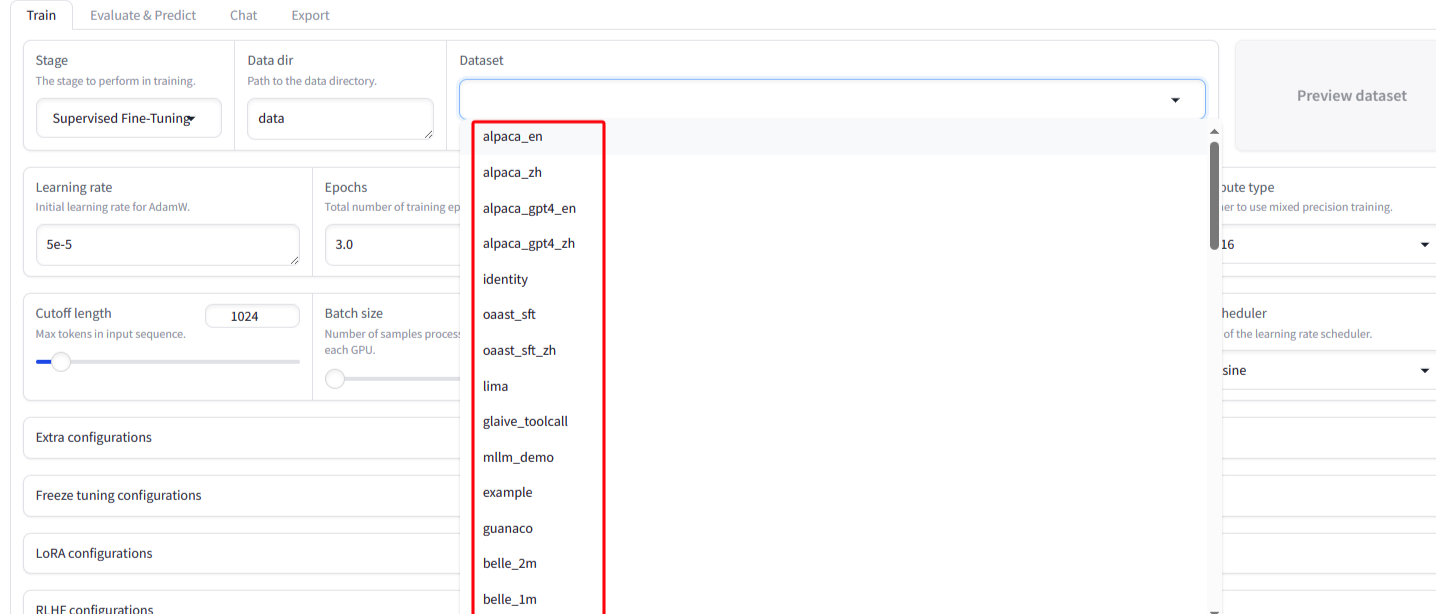

在dataset中即可选择预先准备好的数据集进行微调

点击“Start”开始微调。

导出模型

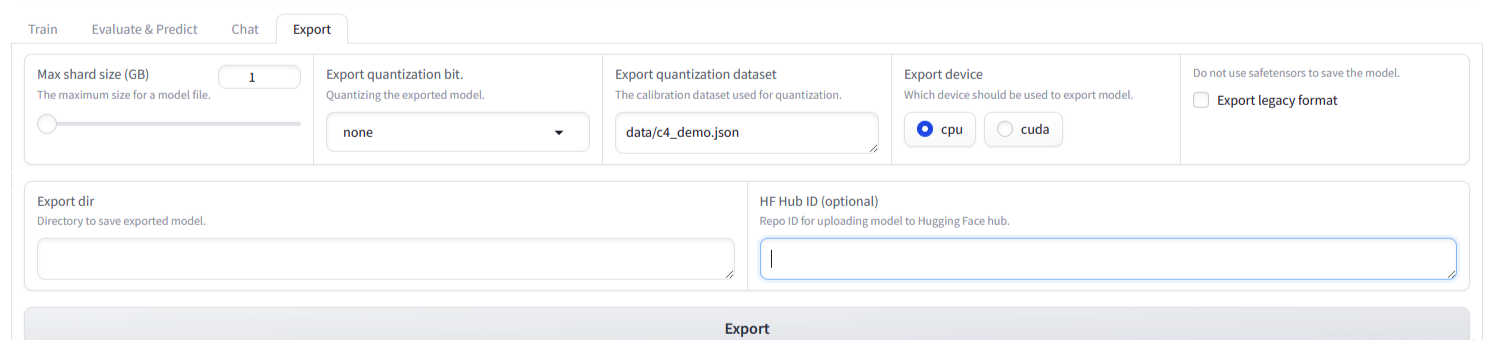

1.微调训练结束之后,点击“Export”选项卡,切换到导出功能区!

2.点击“Refresh adapters”按钮,刷新lora模型,在左侧的下拉列表中选择刚刚训练好的模型!

3.在“Max shard size(GB)”中设置好每个拆分模型的最大size;

4.在“Export dir”中设置模型保存的路径;

5.点击“Export”按钮,开始导出模型(需要点时间等待);